¿Cómo se compone un sesgo algorítmico?

Los algoritmos y códigos desarrollados por humanos, pero ¿Cómo funcionan realmente? ¿Por qué se equivocan?

Disponible en:

Por Sasha Muñoz Vergara. Publicado: 19 de julio de 2021

El reconocimiento facial de los aeropuertos, qué anuncios políticos ves, cómo se examina tu solicitud para tus futuros empleos, cómo diagnosticar si tienes Covid-19 o incluso predecir el riesgo de incendio en tu casa, son decisiones en las que la tecnología está involucrada. Los seres humanos somos propensos a cometer errores, pero eso no significa que los algoritmos sean necesariamente mejores.

¿Qué es el sesgo algorítmico?

Un algoritmo es un conjunto de instrucciones definidas y ordenadas para resolver un problema o realizar una tarea en un computador. Gran parte de todos los conocimientos que compartimos se transmiten en forma de secuencia o de pasos a seguir. Pero estos sistemas pueden estar sesgados en función de quién los construye, cómo se desarrollan y cómo se utilizan finalmente. Es lo que se conoce como sesgo algorítmico.

Es difícil averiguar exactamente cómo los sistemas pueden ser susceptibles de ese tipo de sesgo, porque, según un artículo de Vox sobre este asunto, “esta tecnología suele funcionar en una caja negra corporativa, es decir, no sabemos cómo se diseñó una inteligencia artificial o un algoritmo concreto, qué datos ayudaron a construirlo o cómo funciona.”

Los algoritmos se entrenan con datos

El machine learning, o “aprendizaje automático” (un tipo de inteligencia artificial), es una forma de “entrenamiento”. Se trata de exponer un ordenador a un montón de datos, para que luego ese ordenador aprenda a hacer juicios, o predicciones, sobre la información que procesa basándose en los patrones que observa.

Por ejemplo, digamos que quieres entrenar a un sistema informático para que reconozca si un objeto es un libro, basándose en algunos factores, como su textura, peso y dimensiones. Un humano podría hacerlo, pero un ordenador podría hacerlo más rápidamente.

“Para entrenar el sistema, se le muestran al ordenador las métricas atribuidas a un montón de objetos diferentes. Le das al sistema informático las métricas de cada objeto y le dices cuándo los objetos son libros y cuándo no. Después de probar y perfeccionar continuamente, se supone que el sistema aprenderá lo que indica un libro y, con suerte, podrá predecir en el futuro si un objeto es un libro, en función de esas métricas, sin ayuda humana”, dice este video de Google que explica cómo funcionan los sesgos en el aprendizaje automático.

Todos estamos sesgados hacia una forma de pensar. Imagina intentar enseñar únicamente tu forma de pensar a un computador. Faltaría una infinitud de datos para que la máquina pueda alimentar su base de datos y tener exactamente la respuesta que tú esperas o que otro requiera. Parece relativamente sencillo. Incluir en el primer lote de datos una gama de diferentes e irrepetibles tipos de elementos, pero es más complejo que esto.

¿Qué impacto tienen los sesgos algorítmicos?

Estos sistemas suelen aplicarse a situaciones que tienen consecuencias mucho más graves que la tarea de identificar libros, y en escenarios en los que no hay necesariamente una respuesta “objetiva”. Usualmente, la tanda de datos que se ingresan en los algoritmos no son completos o seleccionados cuidadosamente, por lo que estos pueden caer en un sesgo discriminatorio.

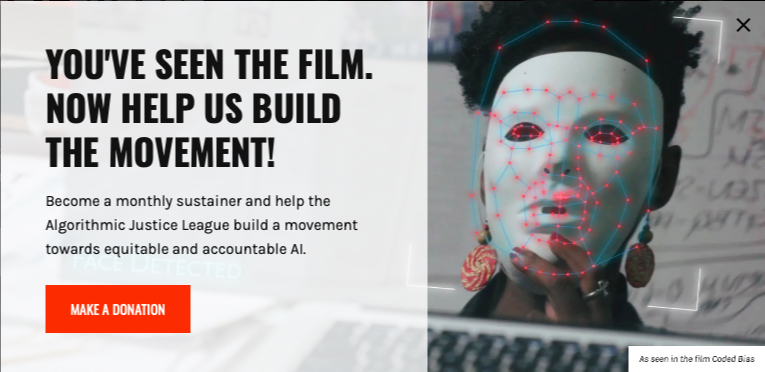

Un ejemplo de ello se expuso en la investigación Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification, _discutida también en el documental Coded Bias_, un documental dirigido por Shalini Kantayya. Este estudio navegó a través de otros para concluir que muchas de las herramientas utilizadas hoy en día para el reconocimiento facial se sustentan en algoritmos entrenados con datos sesgados y discriminatorios, en especial a partir de género y raza.

Otro estudio encontró que un computador programado para que automáticamente aprenda el idioma inglés contiene sesgos discriminatorios hacia las personas de raza negra. ¿Qué rasgos faciales recogía este programa para el análisis? ¿Se trata de los rasgos físicos de ciertos grupos étnicos que son discriminados en el sistema judicial? Los algoritmos son poderosos, pero más lo es el tipo de datos con el cual alimentas a dichos algoritmos para enseñarles a sesgar.

¿Qué se está haciendo para combatirlo?

Fuente: The Algorithmic Justice League

La estudiante de posgrado del MIT Joy Buolamwini estaba trabajando con un software de análisis facial cuando se dio cuenta de un problema: el software no detectaba su cara, porque las personas que codificaron el algoritmo no le habían enseñado a identificar una amplia gama de tonos de piel y estructuras faciales. Es así como funda la Liga de la Justicia Algorítmica, cuyo objetivo es crear conciencia sobre las implicaciones sociales de la inteligencia artificial a través del arte y la investigación.

Hay una esperanza para esto. Buolamwini indica que no estamos limitados a solo una base de datos para entrenar computadoras, podemos crear cuantas series de datos sean posibles, que “reflejen de manera más exhaustiva un retrato de la humanidad”, según mencionó en una de sus charlas Ted Talk.

Otra solución para volver más “exactos” a los algoritmos sería regularlos por ley, pero el actual marco regulador de la tecnología es en gran medida reactivo. Consideremos la multa de 5.000 millones de dólares de la Comisión Federal de Comercio (FTC) contra Facebook por violaciones de la privacidad de los datos. No contiene prácticamente ningún mecanismo técnico de aplicación, solo humanos y organizativos.

Según este artículo sobre algoritmos éticos, un enfoque alternativo es permitir que los reguladores tecnológicos sean proactivos en su aplicación e investigaciones. Así, si, por ejemplo, hay un sesgo de género podría ser descubierto por los reguladores en un experimento controlado, confidencial y automatizado con acceso de caja negra al modelo que luego saldrá al mercado.